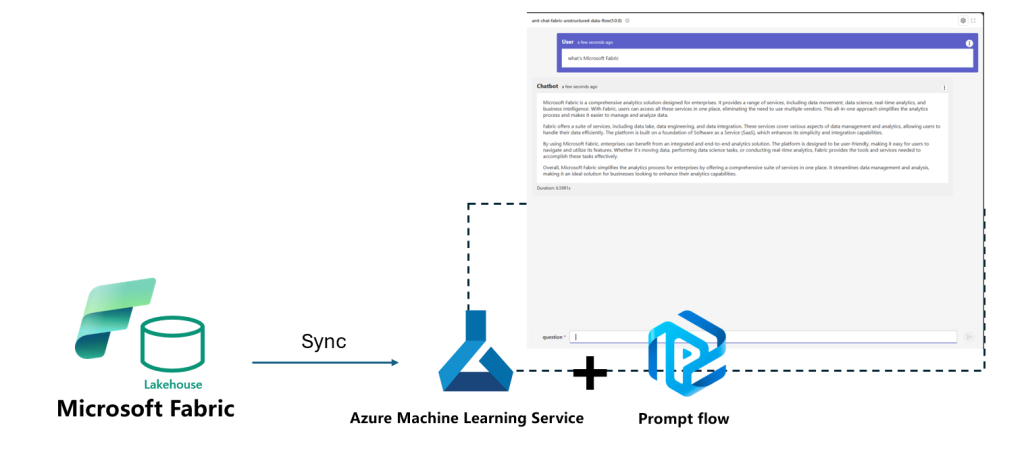

Usando Lakehouse Data do Microsoft Fabric e fluxo imediato no Azure Machine Learning Service para criar aplicativos RAG

O Lakehouse da Microsoft Fabric nos ajuda a melhorar o gerenciamento unificado de ambientes de dados de nível empresarial. No processo de transformação para IA, não podemos prescindir da assistência destes dados empresariais. Em meu blog anterior, mencionei como construir aplicativos RAG com base em dados no ambiente Microsoft Fabric. Nesta postagem, apresentarei como construir um aplicativo RAG por meio de fluxo imediato em um ambiente de aprendizado de máquina mais profissional – Azure Machine Learning Service combinado com dados Lakehouse do Microsoft Fabric.

O Azure Machine Learning Service é uma plataforma de aprendizado de máquina que gosto de usar, cobrindo o processo de aprendizado de máquina de dados, treinamento, testes, implantação, monitoramento, etc. Podemos introduzir rapidamente os dados do Microsoft Fabric Lakehouse no Azure Machine Learning Service por meio de um pequeno script .

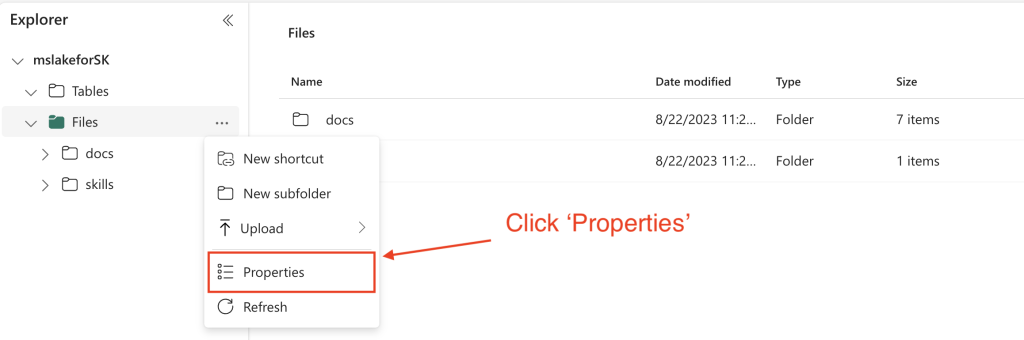

1. Obtenha o caminho ABFS de Lakehouse no Microsoft Fabric.

Escolha o Lakehouse do seu Microsoft Fabric, clique em Arquivos -> Propriedades.

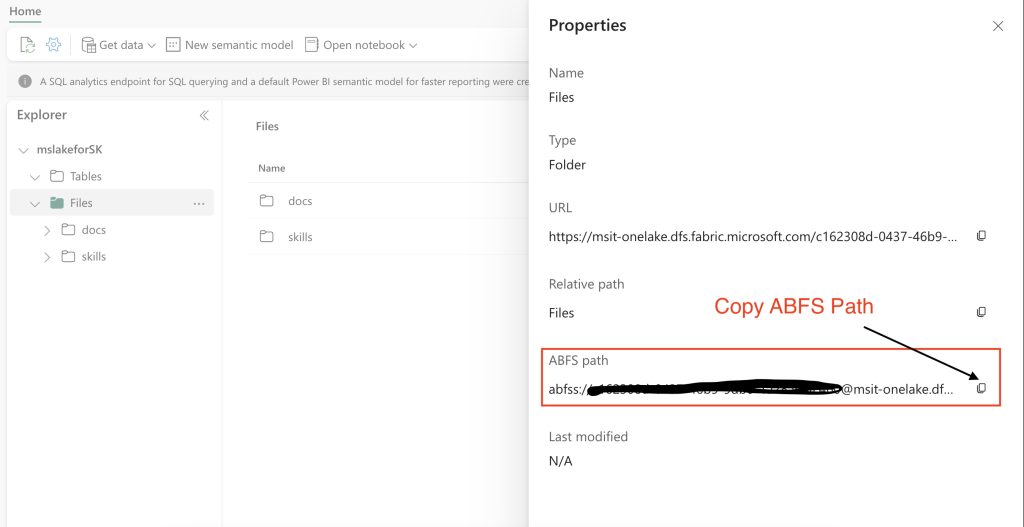

Copiar caminho ABFS

abfss://@msit-onelake.dfs.fabric.microsoft.com/ <One Lake workspace name>/ <Lakehouse ID>Arquivos

2. Crie um novo Notebook em sua máquina local. Execute o código a seguir para importar dados do Lakehouse para o Azure Machine Learning Service

! pip install azure-ai-ml -U

! pip install mltable azureml-dataprep[pandas] -U

! pip install azureml-fsspec -U

from azure.ai.ml import MLClient

from azure.identity import DefaultAzureCredential

from azure.ai.ml.entities import OneLakeDatastore, OneLakeArtifact

subscription_id = "Your Azure Subscription ID"

resource_group = "Your Azure Machine Learning Service Workspace Resource Group"

workspace = "Your Azure Machine Learning Service Workspace Name"

ml_client = MLClient(

DefaultAzureCredential(), subscription_id, resource_group, workspace

)

artifact = OneLakeArtifact(

name=<Lakehouse ID>,

type="lake_house"

)

store = OneLakeDatastore(

name="onelake_lh_for_azureml",

description="Credential-less OneLake datastore.",

endpoint="msit-onelake.dfs.fabric.microsoft.com",

artifact=artifact,

one_lake_workspace_name=<One Lake workspace name>,

)

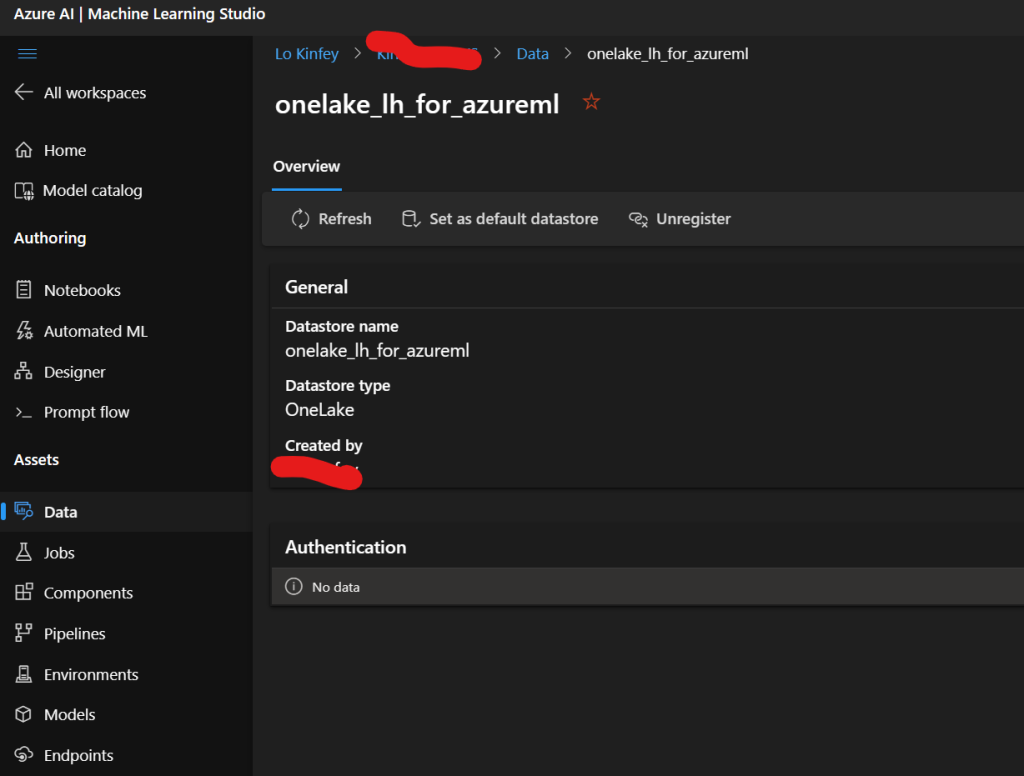

ml_client.create_or_update(store)3. Teste os dados para ver se foram importados com sucesso.

from azure.ai.ml.constants import AssetTypes, InputOutputModes

from azureml.fsspec import AzureMachineLearningFileSystem

uri = 'azureml://subscriptions/<Your Azure Subscription ID >/resourcegroups/<Your Azure Machine Learning Service Resource Group>/workspaces/<Your Azure Machine Learning Service Workspace Name>/datastores/onelake_lh_for_azureml'

# create the filesystem

fs = AzureMachineLearningFileSystem(uri)

fs.ls()

with fs.open('Files/csv/sales.csv') as f:

data = f.readlines()

print(data[0:5])

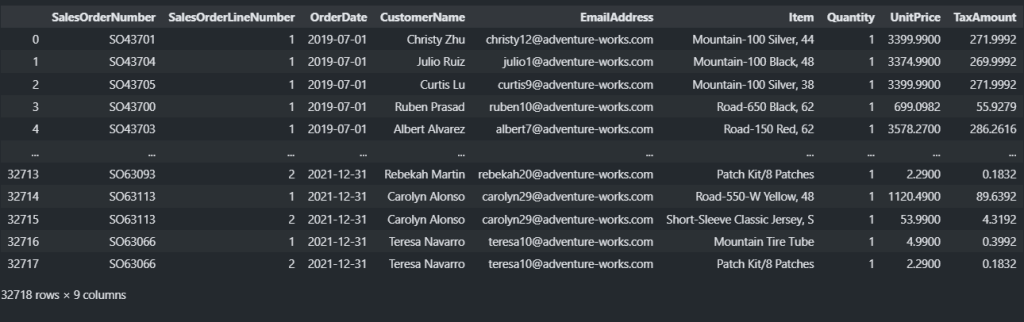

f.close()Você pode selecionar Dados do Serviço Azure Machine Learning para ver se os dados relevantes são importados com sucesso.

from azure.ai.ml.entities import Data

import pandas as pd

import mltable

csv_path = 'azureml://datastores/onelake_lh_for_azureml/paths/Files/csv'

my_csv_data = Data(

path=csv_path,

type=AssetTypes.URI_FOLDER,

description="demo",

name="csv_data_source",

version="1.0.0"

)

ml_client.data.create_or_update(my_csv_data)

csv_data = ml_client.data.get("csv_data_source", version="1.0.0")

path = {

'folder': csv_data.path

}

tbl = mltable.from_delimited_files(paths=[path])

df = pd.read_csv( csv_data.path + '/sales.csv')

df

Claro, você também pode verificar os dados no espaço de trabalho do Azure Machine Learning Service para ver se estão bem sincronizados.

No conteúdo anterior usamos Kernel Semântico. Neste blog, usamos o fluxo de prompt para construir o aplicativo. O fluxo de prompt é uma ferramenta de desenvolvimento projetada para agilizar todo o ciclo de desenvolvimento de aplicativos de IA alimentados por Large Language Models (LLMs). À medida que o impulso para aplicativos de IA baseados em LLM continua a crescer em todo o mundo, o Prompt Flow fornece uma solução abrangente que simplifica o processo de prototipagem, experimentação, iteração e implantação de seus aplicativos de IA. Se você está procurando uma ferramenta de desenvolvimento versátil e intuitiva que agilize o desenvolvimento de aplicativos de IA baseados em LLM, o fluxo imediato é a solução perfeita para você.

A maior característica do fluxo imediato é ajudar o projeto Prompt a ser melhor integrado ao projeto. Especialmente na estabilização da saída do LLM, permite escolher o melhor Prompt e combiná-lo com o LLM para um trabalho eficaz.

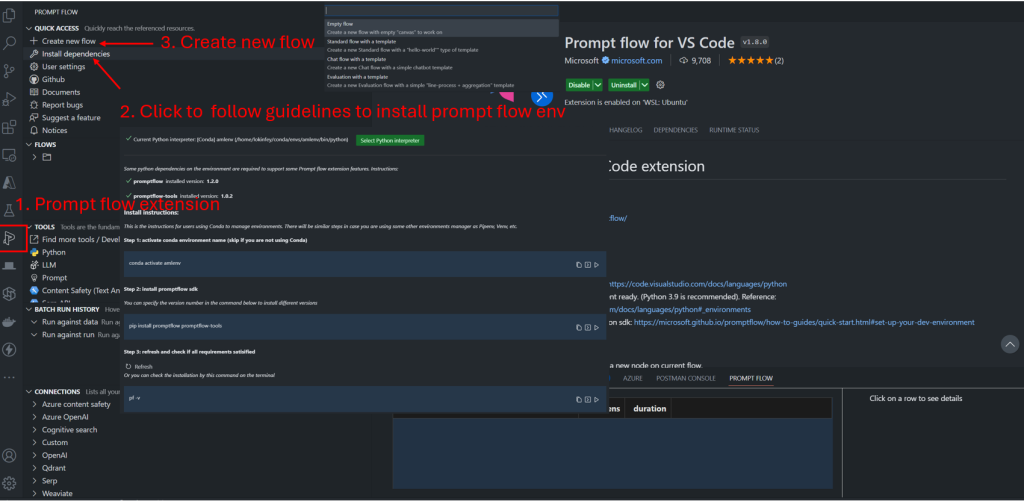

Os aplicativos de desenvolvimento de fluxo de prompt podem ser desenvolvidos no Serviço Azure Machine Learning, na linha de comando ou no Visual Studio Code. É recomendado que você desenvolva no Visual Studio Code. Em primeiro lugar, você precisa instalar o fluxo de prompt para extensões do VS Code.

Após a instalação bem-sucedida, clique nas extensões de fluxo de prompt na barra lateral esquerda e selecione Dependências de instalação. Quando o ambiente for configurado com sucesso, você poderá optar por criar e construir o aplicativo de fluxo Prompt.

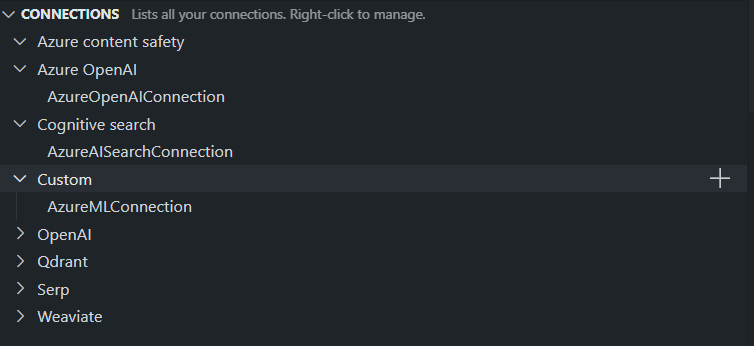

O fluxo de prompt pode dar suporte a diferentes conexões, como o serviço Azure OpenAI, o Azure Cognitive Search, o Azure Content Safety e também dar suporte a conexões personalizadas. Você pode definir conteúdo relevante de acordo com suas necessidades.

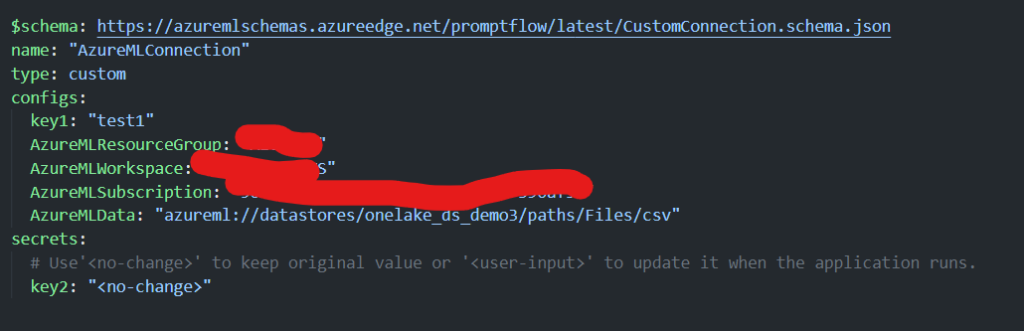

A conexão personalizada é frequentemente usada. Você pode definir algumas configurações de link, principalmente na forma de pares de valores-chave.

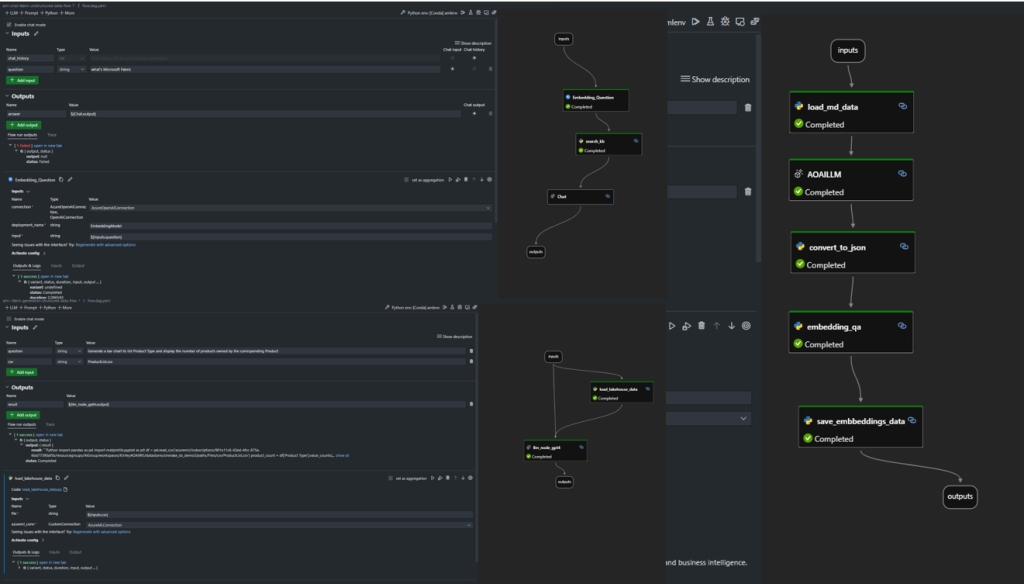

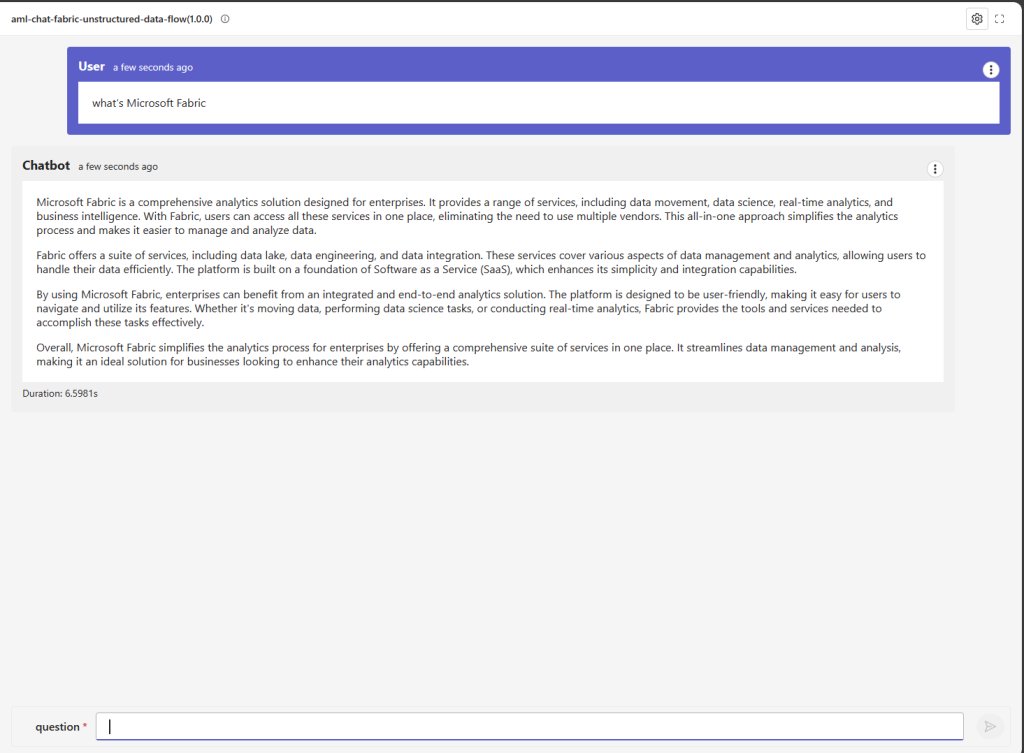

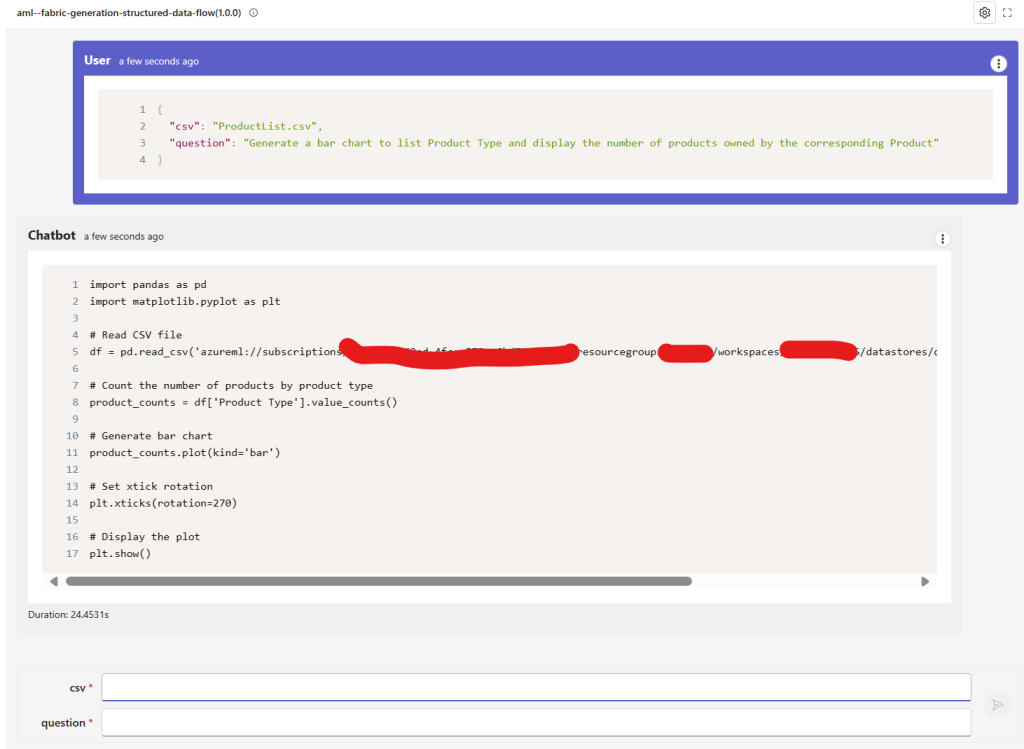

Use o fluxo imediato para criar rapidamente um fluxo para dados corporativos. A seguir estão implementações para dados estruturados e dados não estruturados, bem como um exemplo simples do processo de fluxo do Chat. Todos esses dados vêm do nosso Azure Machine Learning Service (importado do Microsoft Fabric Lakehouse)

Este é um aplicativo RAG para dados não estruturados e dados estruturados construídos por fluxo imediato

Arbit: Especialista em Transformar Tecnologia em Valor!

Pode não ser parecer fácil gerar valor para seus dados, mas a Arbit, pode ajudá-lo. Há 25 anos atuando com inteligência de dados, a Arbit possui especialistas para implementar as melhores soluções ao seu ambiente de negócios. Fale conosco agora mesmo