MLOps Série Parte 4: Testando a segurança de sistemas seguros de Machine Learning usando MLOps

A crescente adoção de soluções orientadas por dados e baseadas em aprendizagem automática está a impulsionar a necessidade de as empresas lidarem com cargas de trabalho crescentes, expondo-as a níveis adicionais de complexidades e vulnerabilidades.

A segurança cibernética é o maior risco para os desenvolvedores e adotantes de IA. De acordo com uma pesquisa divulgada pela Deloitte , em julho de 2020, 62% dos adotantes viam os riscos de segurança cibernética como uma ameaça significativa ou extrema, mas apenas 39% disseram que se sentiam preparados para enfrentar esses riscos.

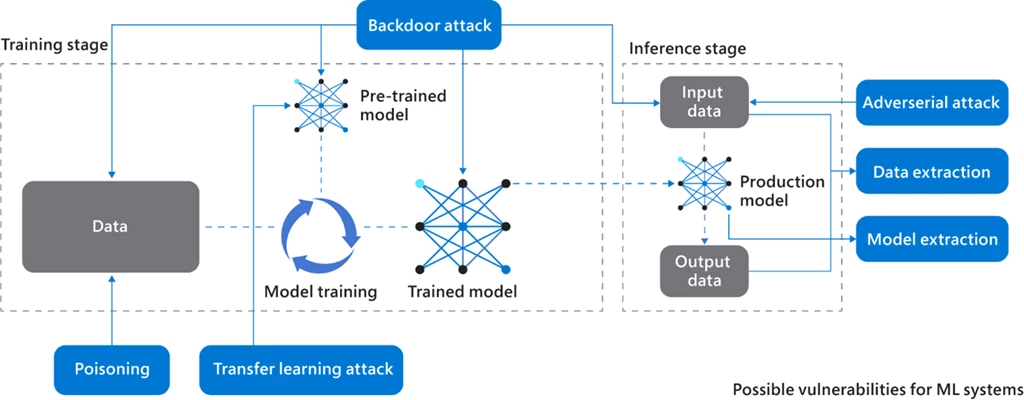

Na Figura 1 podemos observar possíveis ataques a um sistema de Machine Learning (nas etapas de treinamento e inferência).

Figura 1: Vulnerabilidades de um sistema de Machine Learning.

Para saber mais sobre como esses ataques são realizados, confira o livro Engineering MLOps . Aqui estão algumas abordagens e testes importantes para proteger seus sistemas de Machine Learning contra esses ataques:

Criptografia homomórfica

A criptografia homomórfica é um tipo de criptografia que permite cálculos diretos em dados criptografados. Ele garante que a saída descriptografada seja idêntica ao resultado obtido usando entradas não criptografadas.

Por exemplo, criptografar(x) + criptografar(y) = descriptografar(x+y) .

Privacidade desde o design

Privacidade desde o design é uma filosofia ou abordagem para incorporar privacidade, justiça e transparência no design de tecnologia da informação, infraestrutura de rede e práticas comerciais. O conceito traz uma ampla compreensão dos princípios para alcançar privacidade, justiça e transparência. Esta abordagem permitirá evitar possíveis violações de dados e ataques.

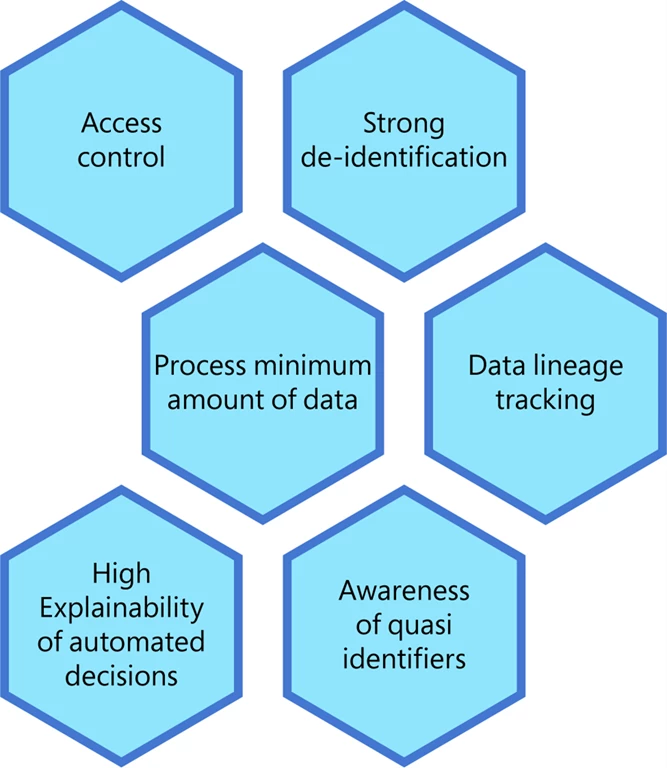

Figura 2: Privacidade desde o projeto para sistemas de Machine Learning.

A Figura 2 descreve alguns fundamentos básicos a serem considerados ao construir um sistema de Machine Learning baseado em privacidade por design. Vamos refletir sobre algumas dessas áreas principais:

- Manter um forte controle de acesso é básico.

- É fundamental utilizar técnicas robustas de desidentificação (em outras palavras, pseudonimização) para identificadores pessoais, agregação de dados e abordagens de criptografia.

- A proteção de informações de identificação pessoal e a minimização de dados são cruciais. Isto envolve a recolha e o processamento da menor quantidade possível de dados em termos de identificadores pessoais associados aos dados.

- Compreender, documentar e exibir dados à medida que eles viajam das fontes de dados até os consumidores é conhecido como rastreamento de linhagem de dados. Isto abrange todas as alterações dos dados ao longo do percurso, incluindo como os dados foram convertidos, o que mudou e porquê. Em um processo de análise de dados, a linhagem de dados fornece visibilidade, ao mesmo tempo que simplifica consideravelmente a capacidade de rastrear violações de dados, erros e causas fundamentais.

- Explicar e justificar decisões automatizadas quando necessário é vital para conformidade e justiça. Mecanismos de alta explicabilidade são necessários para interpretar decisões automatizadas.

- Evitar quase-identificadores e identificadores não exclusivos (por exemplo, género, código postal, profissão ou línguas faladas) é uma boa prática, uma vez que podem ser utilizados para reidentificar pessoas quando combinados.

Dado que a inteligência artificial está a evoluir rapidamente, é fundamental incorporar a privacidade e salvaguardas tecnológicas e organizacionais adequadas no processo, para que as preocupações com a privacidade não sufoquem o seu progresso, mas, em vez disso, conduzam a resultados benéficos.

Monitoramento em tempo real para segurança

O monitoramento em tempo real (de dados: entradas e saídas) pode ser usado contra ataques backdoor ou ataques adversários por meio de:

- Monitoramento de dados (entradas e saídas).

- Acessando a gestão de forma eficiente.

- Monitorando dados de telemetria.

Uma solução importante é monitorar as entradas durante o treinamento ou teste. Para higienizar (pré-processar, descriptografar, transformações e assim por diante) os dados de entrada do modelo, codificadores automáticos ou outros classificadores podem ser usados para monitorar a integridade dos dados de entrada. O monitoramento eficiente do gerenciamento de acesso (quem obtém acesso, quando e onde o acesso é obtido) e dos dados de telemetria pode resultar no conhecimento de quase-identificadores e ajudar a prevenir ataques suspeitos.

Saber mais

Para obter mais detalhes e saber mais sobre a implementação prática, confira o livro Engineering MLOps ou aprenda como construir e implantar um modelo no Azure Machine Learning usando MLOps no webinar sob demanda Get Time to Value with MLOps Best Practices . Além disso, confira nosso blog anunciado recentemente sobre aceleradores de soluções (MLOps v2) para simplificar seu fluxo de trabalho de MLOps no Azure Machine Learning.

Arbit: Especialista em MLOps!

Pode não ser parecer fácil gerar valor para seus dados, mas a Arbit, pode ajudá-lo. Há mais de 20 anos atuando com inteligência de dados, a Arbit possui especialistas para implementar as melhores soluções ao seu ambiente de negócios. Fale conosco agora mesmo